各AIモデルによる第120回医師国家試験の解答精度の評価

本記事の更新情報

・2月17日16時15分:AI回答の検証内容を更新しました.・2月8日21時00分:D~FブロックのAI回答とまとめを公開しました.各問題の詳細な検証については後日更新予定です.

・2月7日19時55分:記事を公開しました.A~CブロックのAI回答を公開しました.

本記事の監修者

|

長嶋大地

医師からAIエンジニアに転身した医療×生成AIの専門家. |

序文

本ページでは,第120回医師国家試験を代表的な各AIサービスに解かせ,結果について検証・考察していく.検証対象は2026年2月時点でのAIモデルである点に留意されたい.

医師国家試験の概要

今回分析対象とするのは,2026年2月7日,8日に実施の第120回医師国家試験である.2日間計400問の試験であり,マークシート形式が採用されている.A~Fブロックの6ブロック構成で,このうちB,Eブロックが必修問題,その他が一般臨床問題である.

合格基準など詳細については,こちらの記事を参照してほしい.

前回検証の振り返り

昨年,こちらの記事にて第119回医師国家試験で同様の検証を行った. その際は,OpenAI o3-mini-highは一般臨床問題で96.0%という正答率となり,受験生と比較すると第3位相当の成績であった.昨年の時点でかなりの高精度であったが,本年も最新のAIモデルに回答させ,結果を考察していく.

検証対象のAIモデル

今回,第120回医師国家試験を解かせるAIは以下の3モデルである(なお,各社より提供されているAPIを用いて検証を行う).

| モデル名 | 概要 |

|---|---|

| GPT-5.2 Thinking |

提供元 :Open AI API名 :gpt-5.2 ・OpenAI社のGPT-5シリーズにおける最新モデル.ChatGPTではInstant(高速応答),Thinking(推論強化),Pro(最高精度)の3種類が提供されている.推論モデルとして,ユーザーへの出力前に内部で推論トークンを生成し,段階的に問題を解決することで出力精度を向上させている.reasoning effortパラメータにより推論の深さをnone,low,medium,high,xhighの5段階から選択できる.今回はhighを選択. |

| Gemini 3 Pro |

提供元 :Google API名 :gemini-3-pro-preview ・Google社の開発するGeminiシリーズの第3世代における最上位モデルのプレビュー版.テキスト・画像・音声・動画のマルチモーダル入力に対応し,最大100万トークンのコンテキストウィンドウを持つ.thinking_levelパラメータによりlow,highの2段階で推論の深さを制御できる.今回はhighを選択. |

| Claude Opus 4.5 |

提供元 :Anthropic API名 :claude-opus-4-5 ・Anthropic社が発表しているLLMのClaude 4.5ファミリーにおける最上位モデル.Haiku,Sonnet,Opusの順にモデルの能力が高くなり,テキストと画像のマルチモーダル入力に対応している.extended thinking機能により,ユーザーへの出力前に内部で推論を行い,回答精度を向上させることができる.budget_tokensパラメータで推論に使用するトークン数の上限を設定でき,今回は1024を選択. |

プロンプト

今回の検証では,以下のプロンプト(指示文)を用いることでAIに医師国試を解かせた.

なお,120回医師国試の問題文については記事執筆時点では厚生労働省よりPDFが公開されていないため,受験生提供の問題冊子をもとに入力した.

あなたは医師国家試験の専門家です。 以下の問題について、段階的に推論して最適な解答を導き出してください。推論プロセス: 問題文を分析し、問われていることを明確化 各選択肢を医学的知識に基づいて評価 鑑別診断や病態生理を考慮して最適解を決定 他の選択肢が不適切な理由も簡潔に考察

回答ルール: 指示がない限り1つだけ選択 複数選択の指示がある場合のみ複数可(アルファベット順で記載) 最終的に以下のJSONで出力: (JSONの例)

医師国家試験では,テキストのみで表せる問題と,医療画像や表組みを含んだ問題が混在している.昨年の検証では,画像入力非対応のAIモデルも利用していたため,問題が画像を含むか否かで正答率の検証を分けた.これに対し本年の検証では,検証対象のLLMすべてが画像入力に対応していることから画像問題を含む全問題の結果のみを検証対象とする.

AIによる120回医師国家試験の回答

以下に,各AIモデルの回答を順次まとめていく.なお,検証にあたっては「解答」の他に「解答の確信度」「解答の根拠」も出力させているが,スペースの都合上ここでは割愛する.

Aブロックの回答まとめ

Bブロックの回答まとめ

Cブロックの回答まとめ

Dブロックの回答まとめ

Eブロックの回答まとめ

Fブロックの回答まとめ

AIによる回答の精度検証

AIによる回答の検証が進み次第,本項にて随時まとめていく.なお,厚生労働省より120回医師国家試験の解答が発表されるまでは,弊社採点サービス「講師速報」にて公開している解答速報をもとに成績を検証する.

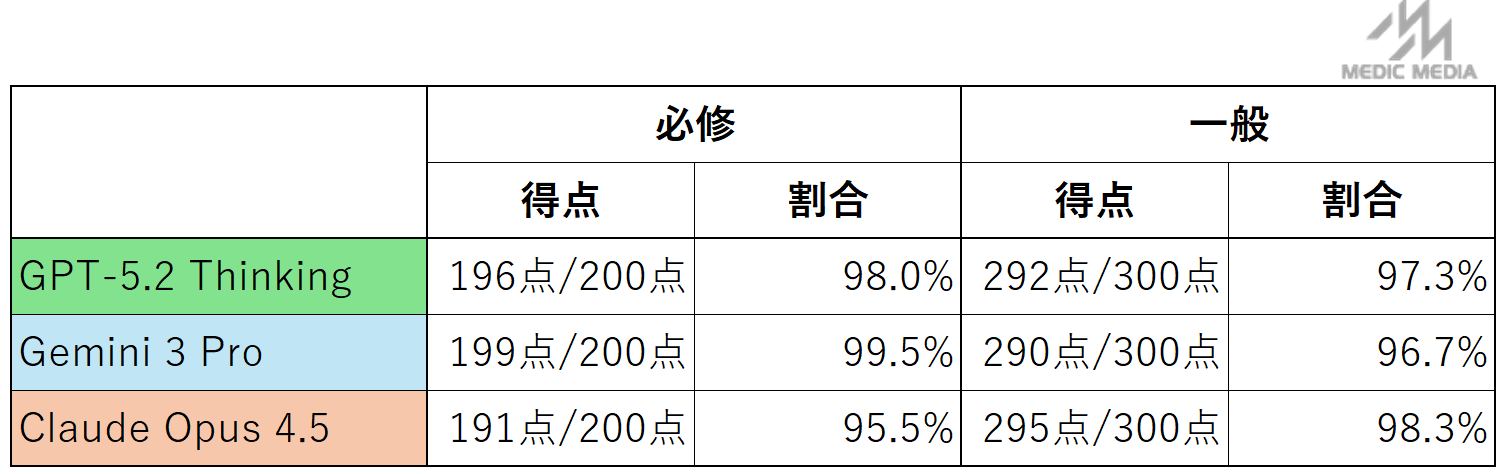

120回医師国家試験の各AIモデルの成績は以下の通りである.

上記結果から分かる通り,必修はGemini 3 proが,一般臨床はClaude Opus 4.5が最も成績が良かった.しかし,いずれのモデルも極めて高い水準であり大きな差はなかった.

また,3モデルのいずれも間違えた問題は0問であった.

一般臨床問題の成績について,Claude Opus 4.5の98.3%という正答率は仮に国試受験生とすると第1位の成績である(※弊社解答速報サービス「講師速報」に2月8日21時時点で入力している約5,000人の成績と比較した).また,必修問題については,Gemini3 proは1問間違いの得点率99.5%であった.合格基準が80%であることを考えると,こちらも極めて好成績である.

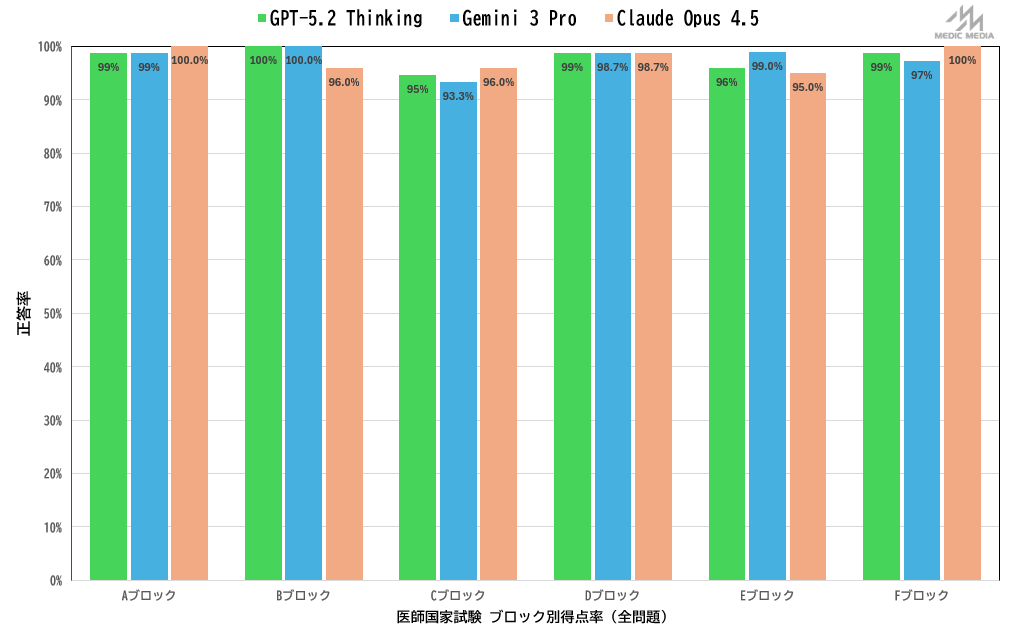

ブロック別の傾向を見ると,公衆衛生の比重が高いCブロックにおいては,他のブロックと比較して各モデルとも正答率がわずかに伸び悩む結果となった. これは,Cブロックで出題された日本国内における法制度・統計データの問題について,各LLMが苦手としている可能性がある.

AIの解答の考察

複数のAIが間違えた問題のうち,いくつかを以下にピックアップした.

全体の傾向としては119回と同様,日本特有の問題(特に公衆衛生に関連する問題)や優先度をつける問題の正答率が低いといえる.

A-41

【正答】c

【AIの誤答】e (GPT, Gemini)

【各モデルの出力】

Claude[c]「術後食事開始後の白濁排液は乳び胸を示唆.胸管・リンパ管損傷による乳び漏出であり,バイタル安定のため保存的治療として低脂肪食(MCT使用)が第一選択.改善なければTPN→手術へ移行する.」

GPT[e]「食事開始後の白濁胸水は術後乳び胸が疑われ,まず絶食として胸管流量を減らすためTPNを行う.」

Gemini[e]「術後乳糜胸の診断.食事開始後に排液が白濁(乳糜)しており,食事中の脂肪分がリンパ管(胸管)から漏出している.治療は保存的治療が第一選択であり,腸管からのリンパ流量を最小限にするため,絶食および完全静脈栄養(TPN)を行うのが最も確実で標準的な対応である.」

【考察】

いずれのAIモデルも「症例が乳び胸であり,保存的治療をするべき」であると判断した.しかし,保存的治療として検討しうる「c 低脂肪食」と「e 完全静脈栄養」の双方について優先順位を議論して正答したのはClaudeのみであった.GPTおよびGeminiはこの点に考察なく「e 完全静脈栄養」を選択しており,プロンプト文「他の選択肢が不適切な理由も簡潔に考察」への追従が不十分であった.なお,直近の医師国家試験で出題された乳び胸(117A35)では,2Lもの廃液があり「中心静脈栄養」を正答とするものであった.この出題が今回の推論に影響した可能性が考えられる.

B-14

【正答】e

【AIの誤答】b (Claude)

【各モデルの出力】

Claude[b]「便検体は室温保存が原則.赤痢菌やカンピロバクターなど腸管病原菌は低温に弱く,冷蔵すると死滅するため.他の検体は細菌増殖防止のため冷蔵保存.」

GPT[e]「血液培養は低温で菌が失活し得るため原則室温で速やかに提出する.」

Gemini[e]「血液培養ボトルは,低温で一部の菌(髄膜炎菌など)が死滅する恐れがあるため,冷蔵せず室温保存が原則である.一方,尿・便・喀痰などは常在菌の過剰増殖を防ぐため冷蔵保存する.」

【考察】

いずれのAIモデルも,室温保存と低温保存を検討し,細菌の失活・死滅の観点から低温保存に適さない検体を判断した.GPTおよびGeminiは,適切に「e 血液」と回答した一方で,Claudeは「b 便」と誤答した.

本来無菌である血液検体と,常在菌が過剰増殖しやすいその他の検体という俯瞰的な対比が求められるが,Claudeは「赤痢菌,カンピロバクターなどの腸管病原菌が低温に弱い」ことを指摘しており,枝葉末節にこだわって推論を誤ったようであった.

C-9

【正答】e

【AIの誤答】c (GPT, Gemini)

【各モデルの出力】

Claude[e] 「2023年国民生活基礎調査では,高齢者世帯のうち単独世帯の割合は約51%であり,50%に最も近い.高齢化と核家族化の進行により単独世帯は増加傾向にある.」

GPT[c]「高齢者世帯に占める単独世帯は約3割強(約33%)で,最も近いのは30%.」

Gemini[c] 「2023(令和5)年国民生活基礎調査において,高齢者世帯のうち単独世帯の割合は31.8%である.夫婦のみの世帯(32.1%)とほぼ同水準で,約3割を占めている.」

【考察】

検証の段階では,Claudeが「e 50%」,GPTとGeminiが「c 30%」と回答した.その後検索機能をオンにして再出力したところ,本文の出題意図である2023年国民生活基礎調査のデータを参照することができ,正答「e」が回答された.

米国製AIモデルが日本における直近の統計データに必ずしも適切に学習できていないことが示唆された.

C-11

【正答】e

【AIの誤答】a (GPT)

【各モデルの出力】

Claude[e]「保険医の登録は健康保険法で規定されており,医師法には規定されていない.医師国家試験,医籍登録,臨床研修は医師法に規定.共用試験は2023年から医師法に組み込まれた.」

GPT[a]「医師法は国試・医籍登録・臨床研修を規定.共用試験(CBT/OSCE)は法定外.」

Gemini[e]「医師国家試験,医籍,臨床研修は医師法に規定されています.共用試験も法改正により医師法に位置づけられました.一方,保険医の登録は健康保険法に規定されています.」

【考察】

要点は2つあり,1)法改正され共用試験(CBT,OSCE)が医師法に位置づけられたこと,2)保険医の登録は我が国では健康保険法に規定されていることである.ClaudeとGeminiはいずれもこの2点に言及し「e」と正答した.一方で,ChatGPTは「医師法は国試・医籍登録・臨床研修を規定」という旧来事実に言及し,「共用試験(CBT,OSCE)は法定外」とした.日本の最新法規のデータが必ずしも米国製AIモデルに反映されていない現状を映し出しているといえるだろう.

C-38

【正答】c

【AIの誤答】b (Claude,Gemini)

【各モデルの出力】

Claude[b]「妊娠中のカルシウム拮抗薬は催奇形性の懸念があり,ACE阻害薬は胎児毒性で禁忌.メチルドパは妊娠中の高血圧治療の第一選択薬であり,挙児希望の段階で変更するのが適切.」

GPT[c]「Ca拮抗薬は妊娠中も比較的安全で継続可.ACE阻害薬は胎児腎障害で禁忌.」

Gemini[b]「妊娠希望の本態性高血圧患者では,催奇形性等のリスクを避けるため,妊娠前から妊娠中に使用可能な安全な降圧薬(メチルドパ,ラベタロール,ニフェジピンなど)への変更を行うのが原則である.」

【考察】

妊娠中のカルシウム拮抗薬投与に関する,直近の厚生労働省の通知の扱いや安全配慮の観点に,AIごとの差が現れた興味深い問題である.近年,厚生労働省から「カルシウム拮抗薬2剤(アムロジピンベシル酸塩及びニフェジピン)の「使用上の注意」の改訂について」が通知された.この通知にあるように,カルシウム拮抗薬は妊娠中も比較的安全で継続が可能であり,「c」が正答である.

しかし,カルシウム拮抗薬には催奇形性が懸念されてきたこれまでの経緯があり,一般に妊娠への降圧薬として最も安全な選択肢はメチルドパとされる.ClaudeとGeminiは「b」のメチルドパへの変更を選択しており,従来の安全配慮の観点を重視した選択であると言える.一方で,ChatGPTは本態性高血圧症に主に使われるカルシウム拮抗薬は継続すべきであるとして正答「c」を選択しており,最新の知見および本問の状況設定に基づいた選択であると言える.

医療AIの社会実装に向けて議論が活発化する中,最新の知見に基づいた選択と,歴史的により安全とされている選択では,人工知能はどちらをより重視すべきか.AIモデルごとに基づいている規範が異なる可能性を感じ取れるケースであった.

【参考】

Web:【厚労省通知】カルシウム拮抗薬2剤「使用上の注意」の改訂についてhttps://www.jpnsh.jp/topics_group/754.html

当該PDF(カルシウム拮抗薬2剤(アムロジピンベシル酸塩及びニフェジピン)の「使用上の注意」の改訂について)

https://www.mhlw.go.jp/content/11120000/PMDSI_No.398.pdf

C-67

【正答】a

【AIの誤答】e (Gemini)

【各モデルの出力】

Claude[a]「新生児蘇生法における保温では,インファントウォーマー,暖かいタオル,帽子,プラスチックラップが用いられる.温風は気流により熱喪失を促進するため使用しない.」

GPT[a]「NRPの保温は放射加温器・乾燥タオル・帽子・ラップ等.温風は標準手技でない.」

Gemini[e]「NCPRガイドラインでは,在胎32週未満または出生体重1,500g未満の早産児に対してプラスチックラップ/バッグの使用(拭かずに包む)が推奨される.本症例は36週,2,400gであるため,温かいタオルによる羊水の拭き取り(ドライ)を行う.」

【考察】

Geminiは,本症例における「c 暖かいタオル」と「e プラスチックラップ」の使用を検討し,ガイドライン上優先順位の劣る「e プラスチックラップ」を”用いないもの”として選択した.これは,モデルがNCPRガイドラインに基づく推論を行う過程で,問題文の本来の意図である「新生児蘇生法における保温で用いない手法を選ぶ」ことを忘却して導いた結論と考えられる.

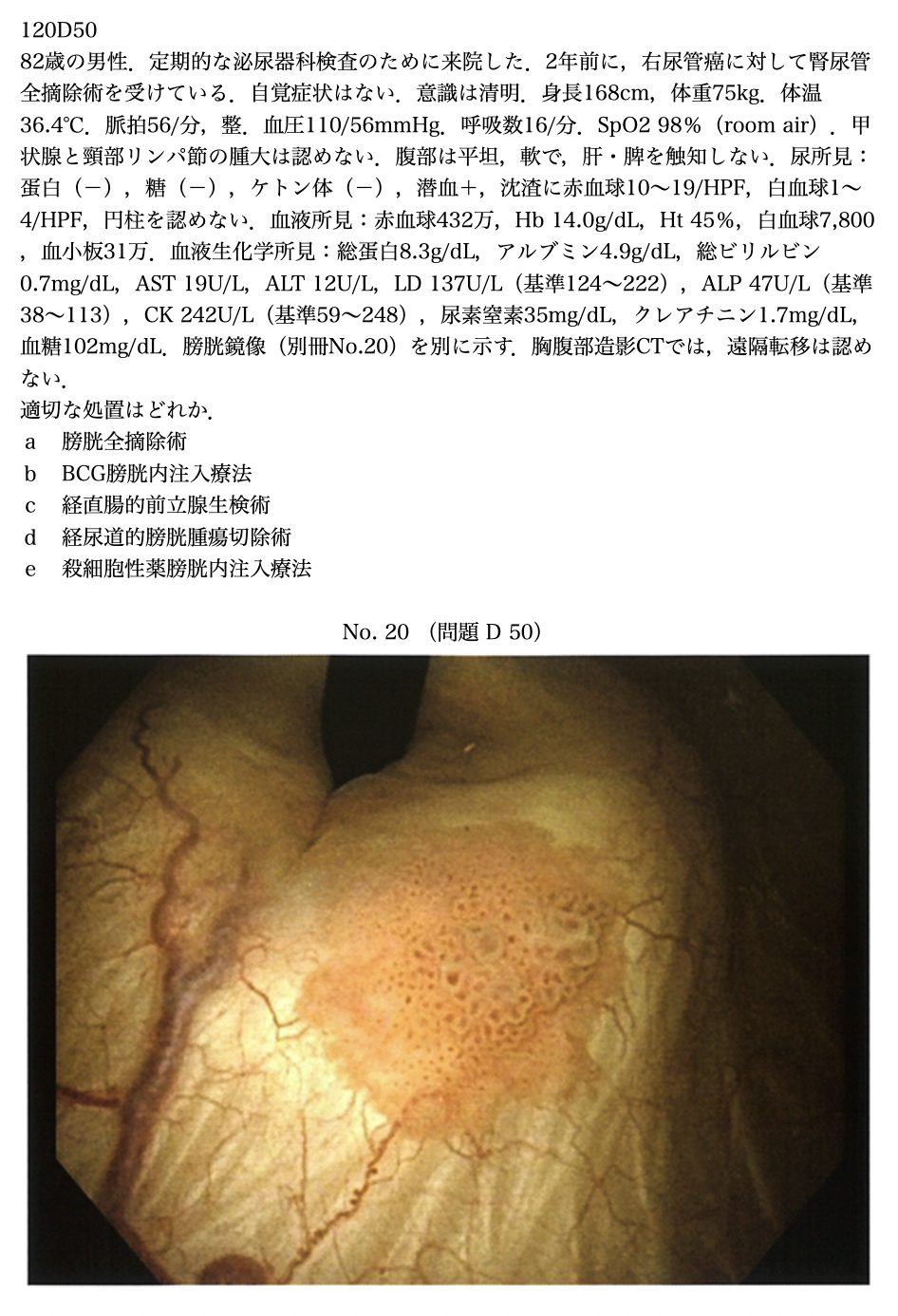

D-50

【正答】d

【AIの誤答】b (GPT)

【各モデルの出力】

Claude[d]「尿管癌術後患者の膀胱鏡で乳頭状腫瘍を認める.尿路上皮癌は多発再発しやすく,膀胱腫瘍の診断・治療の第一選択はTURBT.組織診断と深達度評価が必要.」

GPT[b]「膀胱鏡は平坦な紅斑状病変でCIS疑い.非筋層浸潤癌の高リスクにはBCG膀胱内注入が第一選択.」

Gemini[d]「画像はCIS(上皮内癌)を強く示唆する平坦な発赤病変である.確定診断と病期診断のために,まずは経尿道的膀胱腫瘍切除術(TURBT)を行い,組織を採取する必要がある.BCG注入は診断確定後の治療である.」

【考察】

いずれのAIモデルも画像所見から膀胱腫瘍を認識し,GPTおよびGeminiは上皮内癌(CIS)を疑った.ClaudeとGeminiは,組織診断と深達度評価を目的に,まずは経尿道的膀胱腫瘍切除術(TURBT)を行うことを正しく選択した.一方,GPTは本症例をCISとして早合点し,「非筋層浸潤癌の高リスクにはBCG膀胱内注入が第一選択」との理由から,「b BCG膀胱内注入療法」と誤答した.これは診断・治療フローが無視され,キーワード対応に推論がひっぱられた結果と考えられる.

E-6

【正答】b

【AIの誤答】e (Claude, Gemini)

【各モデルの出力】

Claude[e]「シリンジ採血の場合,シリンジ内の空気が嫌気性ボトルに入るのを防ぐため,好気性ボトルに先に注入する.これが標準的な血液培養の手技である.」

GPT[b]「血液培養は汚染防止が重要で,採血時は無菌操作として滅菌手袋の使用が適切.」

Gemini[e]「標準的な翼状針(真空採血)による採取では,チューブ内の空気がボトルに入るため,好気性→嫌気性の順に注入するのが正しい.消毒薬は乾燥が必要であり,手袋は未滅菌でも清潔操作ができれば可.」

【考察】

血液培養検体を採取する一連の手技について様々な注意点を扱った出題だが,正答「b 採血時には滅菌手袋を使用する」を選んだのはChatGPTのみであった.

興味深いことに,ClaudeおよびGeminiは共に「e 好気性ボトル,嫌気性ボトルの順に血液を注入する」を選択した.選択理由として「空気が嫌気性ボトルに入るのを防ぐため,好気性ボトルに先に注入する」とあり,根拠と結論に食い違いが見られる.順序に関する日本語表現の扱いに不備がある可能性がある.

また,Geminiは「手袋は未滅菌でも清潔操作ができれば可」と判断し選択肢「b」を除外している.ここでは国試の問題であるというプロトコルの前提部分が軽視され,過度に現場的な判断基準が持ち込まれたように見受けられる.

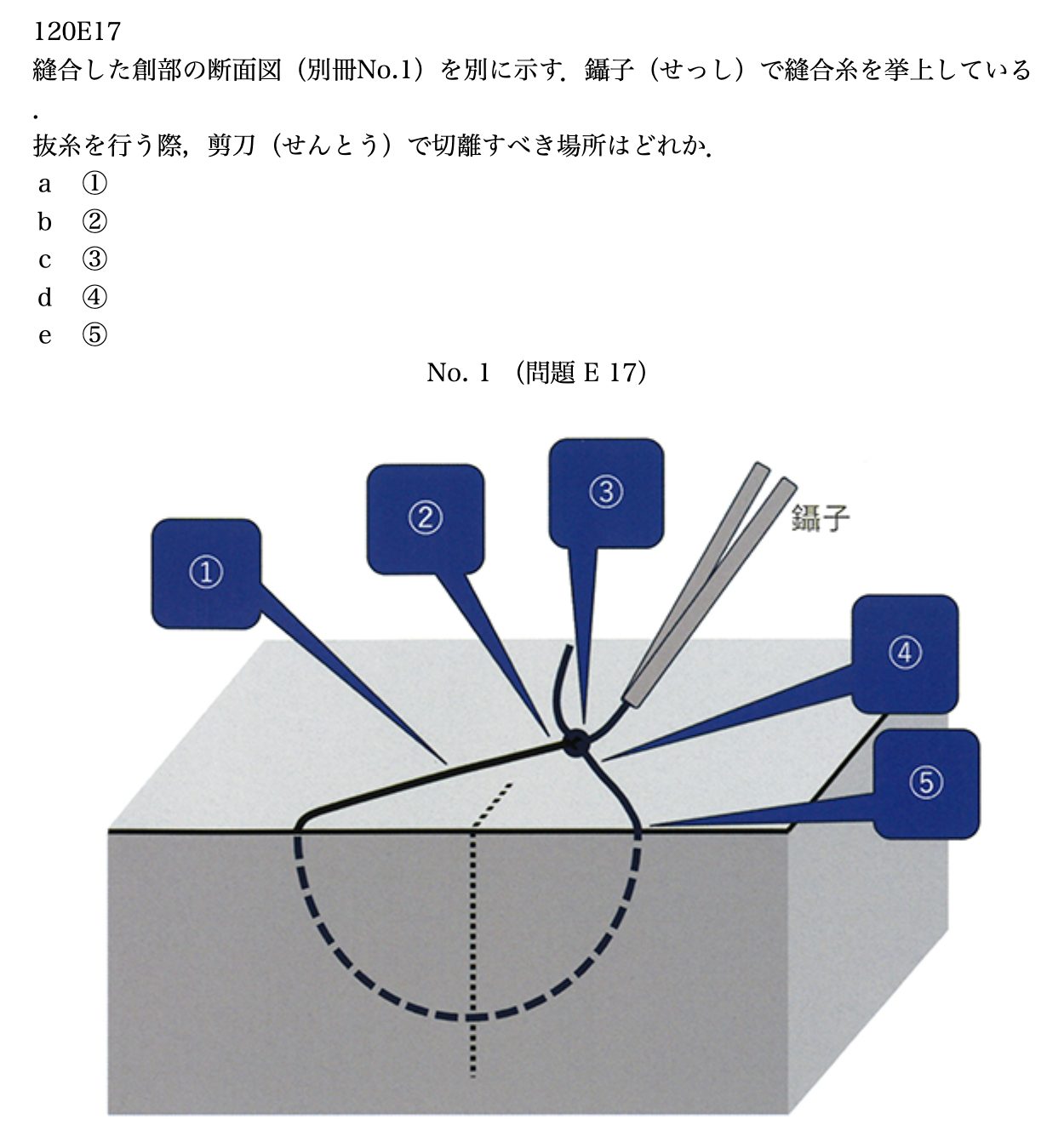

E-17

【正答】e

【AIの誤答】b (Claude), d (GPT)

【各モデルの出力】

Claude[b]「抜糸時は皮膚外に露出していた糸を創内に引き込まないことが原則.②の位置(皮膚直上で結紮部に近い側)で切離し,結紮部側へ引き抜くことで感染を予防できる.」

GPT[d]「抜糸は鑷子で結び目を挙上し,皮膚直上で結節側の短い糸を切ると汚染糸を創内に引かない.」

Gemini[e]「抜糸の原則は,体表に露出して汚染された糸を皮下組織内に通過させないことである.そのため,結び目を持ち上げ,皮膚すれすれの位置(⑤)で切断し,汚染部分が創内を通らないように引き抜く必要がある.」

【考察】

いずれのAIモデルも「抜糸時は皮膚外に露出していた糸を創内に引き込まないことが原則」であることを指摘した.しかしながら,正答「e ⑤」を選択したのはGeminiのみであり,Claudeは「b ②」を,ChatGPTは「d ④」をそれぞれ選択した.

本文は糸の切断箇所を画像から判読する必要がある.昨今,各AIモデルは画像認識能力を急速に進歩させているが,本文ではGeminiだけが出題イラストの意図を正確に汲み取ったと考えられる.

結論

今回の検証において,GPT,Gemini,Claudeのいずれのモデルも極めて高い正答率を記録した.合格ラインを遥かに上回る水準であり,受験生のトップクラスに相当する成績である.

AIが不正解となった設問の内訳を見ると,画像の読み取り精度に起因するものや.日本の公衆衛生・法律・統計といった特有の知識を問うものが中心であった(詳細については後日更新予定).

しかし,昨年の検証結果と比較すれば明らかな精度向上がみられ,弱点は克服されつつある.

特筆すべきは,「3つのモデルすべてが間違えた問題」が1問も存在しなかったという事実である.

これは各モデルが相互に補完し合えば,理論上は満点に近い解答が可能であることを示唆している.

これらの結果から,医師国家試験はもはやAIモデルの性能差を測るためのベンチマークとはなりえないといえる.

少なくとも医師国家試験レベルの知識に関しては,AIの精度を測定・比較する段階を通り過ぎ,これからは「この高度な能力を持つAIを,医学生の学習にどう効果的に組み込んでいくか」を議論する,新しい時代に入ったといえるだろう.